[논문 리뷰] Sparse Reward Subsystem in Large Language Models

![[논문 리뷰] Sparse Reward Subsystem in Large Language Models](https://images.unsplash.com/photo-1604134774179-44e6adb65dd9?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDZ8fHN3YW58ZW58MHx8fHwxNzcwODE5NjExfDA&ixlib=rb-4.1.0&q=80&w=2000)

LLM 안의 보상 회로를 찾는다: Sparse Reward Subsystem in Large Language Models 읽고, 어디까지 쓸 수 있을까

최근 LLM 추론 성능은 빠르게 좋아졌지만, “왜 잘 푸는지”는 여전히 블랙박스에 가깝습니다. 그래서 실무에서는 모델이 스스로 얼마나 ‘맞을 것 같은지’(confidence)를 말하게 만드는 프롬프트를 붙이기도 하죠.

문제는 그 자기보고식 confidence가 생각보다 잘 안 맞는다는 겁니다. 이 논문에서도 “문제를 풀지 말고 0~1로 confidence 숫자만 내라”는 프롬프트로 얻은 Verbalized Confidence가 정답과의 상관(Spearman)이 0.08에 그쳤다고 보고합니다. 즉, “그럴듯하게 말하는 자신감”을 그대로 믿기는 어렵다는 얘기입니다.

저는 “모델의 confidence를 더 믿을 수 있게 알 수 있다면 LLM as a judge도 더 안전하게 쓸 수 있지 않을까?”라는 생각으로 이 논문을 읽기 시작했습니다.

2026년 2월 공개된 Sparse Reward Subsystem in Large Language Models는 이런 가설을 제시합니다. LLM의 히든 스테이트 안에, 생물학적 보상 시스템과 비슷하게 동작하는 희소(sparse, 1%)한 서브시스템이 있고, 그 안의 일부 차원이 가치와 보상 예측 오차 신호를 담고 있다는 주장입니다.

읽으면서 자연스럽게 이런 질문이 먼저 나왔습니다.

- “그 1%가 범용적 지능이라고 봐도 될까? 이 연구가 AGI를 만드는데 도움이 될까?”

- “이 연구가 어떻게 활용될 수 있을까? 논문에서 제시된 것 말고도 새로운 아이디어를 제시할 수 있을까?”

이 글의 주장은 세 가지입니다.

- 이 논문은 “내적 평가 신호(internal evaluation signal)”가 아주 희소한 병목으로 존재할 수 있음을, 강한 개입(intervention) 실험으로 보여준다.

=> “모델이 속으로 점수 매기는 회로” 같은 게 있고, 그 회로를 건드리면 추론이 크게 망가진다.

- 이 1%는 ‘내적 크리틱(critic), 가치 추정(value estimation)’에 가까운 회로다.

=> “지능 그 자체”라기보다, “잘 풀릴지 판단하는 내부 채점기” 쪽에 가깝다.

- 실무적으로는 confidence 기반 라우팅, 적응형 추론 예산, 온라인 오류 감지 같은 방향으로 확장 가능성이 있다. 다만 내부 보상을 목적함수처럼 쓰면 보상 해킹 위험도 커질 수 있어, 적용 원칙이 필요하다.

이제부터 논문의 핵심 아이디어(무엇을 했는지) → 왜 중요해 보이는지 → 실무에 붙일 때의 설계 아이디어와 주의점을 정리해 보겠습니다.

1. Sparse Reward Subsystem

정의

- 보상 서브시스템(reward subsystem): LLM 히든 스테이트 안에서 정답일 가능성/성공 가능성을 추정하는 신호가 모여 있는 부분.

- 가치 뉴런(value neurons): 현재 상태가 최종적으로 좋은 결과(보상; reward)를 얻을 기대값을 담는 희소한 차원.

- 도파민 뉴런(dopamine neurons): 예측과 실제 보상이 어긋날 때 생기는 보상 예측 오차(RPE) 와 유사한 패턴을 보이는 차원.

여기서 “뉴런(neuron)”은 생물학적 뉴런이 아니라 히든 벡터의 특정 차원(dimension) 입니다. 이 점이 이후 해석에서 매우 중요합니다.

배경

논문은 LLM의 생성 과정을 강화학습(RL) 관점의 흐름으로 다시 봅니다.

- 상태(state): 지금까지의 입력 + 생성된 토큰들

- 행동(action): 다음 토큰 샘플링

- 보상(reward): 최종 답이 맞으면 1, 틀리면 0 같은 이진 보상

핵심은 “답을 다 생성한 뒤”가 아니라, 답을 생성하기 전(초기 입력 상태) 에 이미 모델이 어느 정도 “될 것/안 될 것”을 내부적으로 평가하고 있을 수 있다는 가정입니다.

대상

- 모델/벤치마크로 GSM8K, MATH500, Minerva Math, ARC, MMLU-STEM 등을 사용했습니다.

- 특히 SimpleRL-Zoo 계열(Qwen-2.5-SimpleRL-Zoo)처럼 규칙 기반 보상으로 RLVR(검증 가능한 보상 기반 RL) 을 수행한 모델들을 주요 실험 대상으로 씁니다.

떠오르는 생각

- 이 논문에서 value는 대부분 정답일 확률에 가깝습니다. 유용성(helpfulness), 안전(harmlessness), 인간 선호(preference) 같은 현실의 가치 함수와는 결이 다를 수 있습니다.

- 히든 스테이트는 좌표계(표현 방식)에 따라 같은 정보가 여러 차원의 조합으로도 표현될 수 있습니다. 그래서 “이 차원 자체가 본질”이라고 단정하기보다는, 이 모델이 학습한 표현 좌표계에서 특정 차원들이 value 정보를 특히 많이 담고 있었다 정도로 이해하는 편이 안전합니다. (논문이 틀렸다는 뜻이 아니라, 적용할 때 과대해석을 막기 위한 장치입니다.)

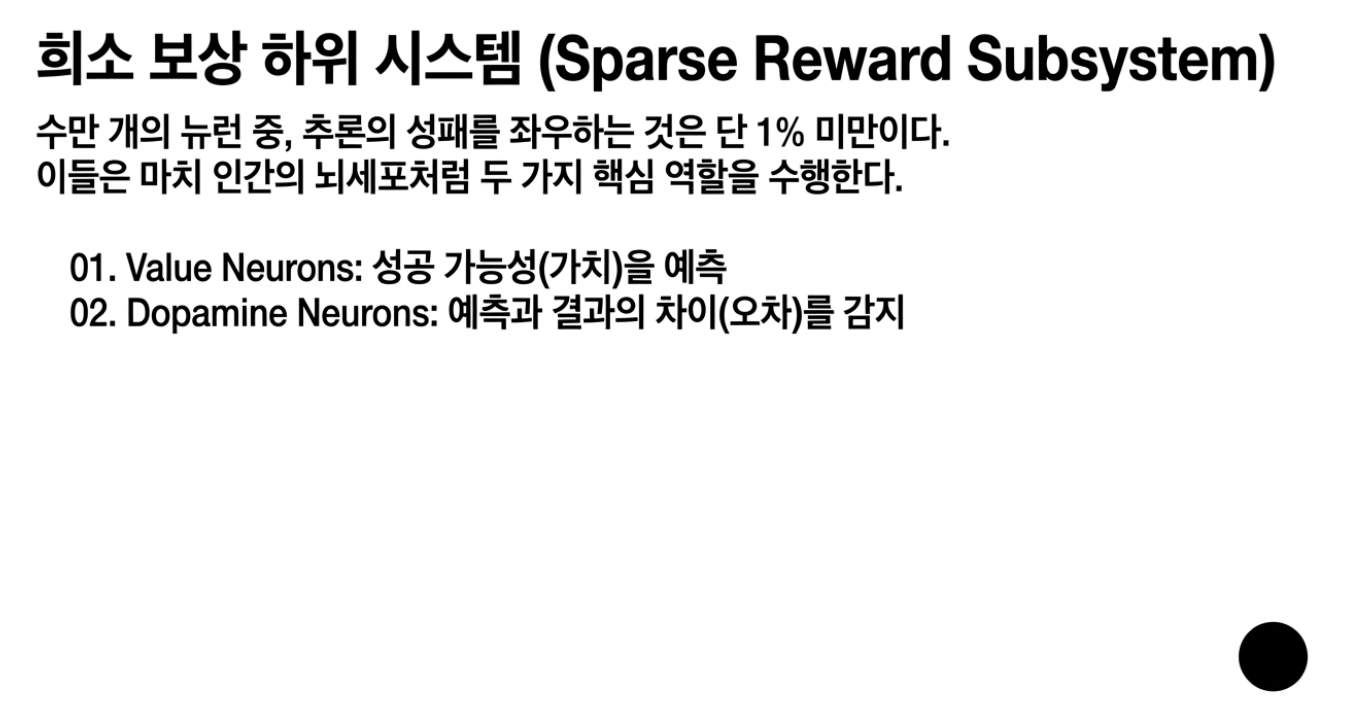

2. 방법: Value probe + pruning으로 value neurons를 찾는 과정

정의

- 프로빙(probing): “히든 스테이트에 어떤 정보가 들어 있나?”를 작은 모델(프로브; probe)로 읽어내는 방법

- 가치 프로브(value probe): 각 레이어의 히든 스테이트를 입력으로 받아, 최종 보상(reward)을 예측하는 작은 MLP

여기서 “무엇을 예측하느냐?”가 핵심인데, 이 논문에서는 최종 정답 여부를 예측합니다.

작동 원리/배경

논문 파이프라인을 요약하면 아래 순서입니다.

- Value probe를 일부러 단순하게 만든다 (2-layer MLP + ReLU)

- 이유: 프로브가 복잡하면, 히든 스테이트를 “읽는 것”이 아니라 프로브가 자체적으로 문제를 풀어버리는 일이 생길 수 있습니다.

- 그래서 논문은 “프로브의 복잡도를 최소화해, 예측이 프로브의 학습 능력보다 히든 스테이트에 이미 들어 있던 구조적 정보를 반영하게 한다”는 취지를 명시합니다.

- TD(Temporal Difference) 방식으로 학습한다

- TD는 “지금의 가치 예측이, 다음 시점의 가치 예측과 일관되도록 맞추는 학습”입니다.

- 마지막 토큰에서는 실제 보상(정답=1/오답=0)과 맞추고, 중간 단계에서는 TD error를 줄입니다.

- 단순히 최종 보상만을 학습하는 것보다 TD 학습이 우월한 이유는, 정답이라는 결과뿐만 아니라 추론이 전개되는 과정의 가치 변화를 정교하게 포착하기 때문입니다.

- 실제로 TD 학습으로 발견한 신경망이 최종 보상만 학습한 경우보다 추론 성능에 더 결정적인 역할을 한다는 것이 확인되었습니다.

- 평가는 답 생성 전에 한다

- 평가 때는 모델이 답을 다 생성한 뒤가 아니라, 초기 입력 상태의 히든에서 value를 뽑아냅니다.

- 그리고 그 값이 최종 정답/오답을 얼마나 잘 구분하는지 AUC로 봅니다.

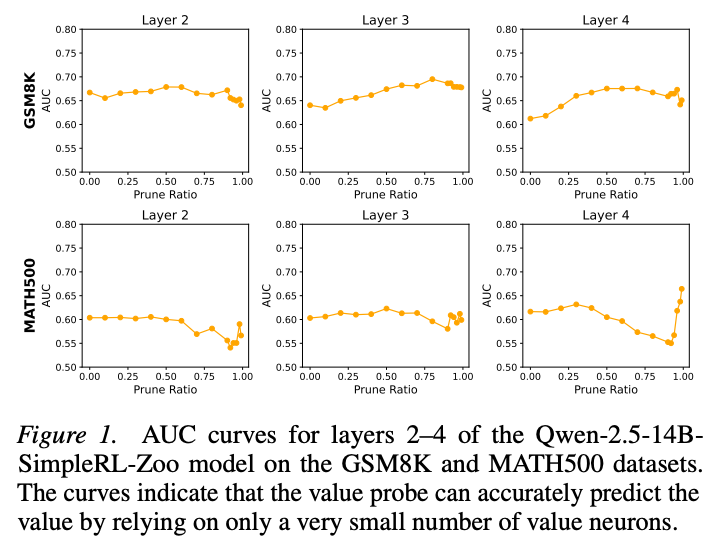

- Pruning으로 희소성(sparsity)을 확인한다

- 입력 차원 중에서 중요도가 낮은 차원을 잘라내고도 AUC가 유지되면, “정보가 소수 차원에 몰려 있다”는 근거가 됩니다.

- 논문은 프로브 1층 가중치의 L1 norm이 작은 입력 차원부터 제거합니다.

Figure 1의 AUC 곡선은 pruning 비율이 커져도(많이 잘라내도) 크게 흔들리지 않습니다. 그리고 논문은 “아주 작은 비율(1% 미만)의 뉴런(차원)만으로도 value를 예측할 수 있다”는 문장을 명시합니다.

떠오르는 생각

- L1 기반 pruning은 실용적이지만, 그게 유일한 방법은 아닙니다. 다른 기준(예: mutual information, integrated gradients, activation patching 등)을 쓰면 다른 집합이 나올 수도 있을 것 같습니다.

- 또한 차원 단위 희소성은 좌표계 회전 등에 취약할 수 있습니다. 이 결과를 신뢰하려면 “좌표계가 바뀌어도 본질이 남는가?” 같은 추가 검증이 필요해보입니다.

3. 상위 1% value neurons 제거 실험

정의

- 개입 및 어블레이션(Intervention/Ablation): 특정 뉴런(차원)의 활성값(activation)을 강제로 0으로 만들어, 해당 요소가 모델의 실제 출력에 어떤 영향을 주는지 확인하는 실험입니다. 단순히 "거기에 정보가 있다"는 상관관계를 넘어, "그게 없으면 작동하지 않는다"는 인과관계를 증명하는 핵심 도구입니다.

배경

논문은 특정 레이어에서 가치 프로브가 찾아낸 상위 1%의 '가치 뉴런'을 제거했을 때, 모델의 추론 성능이 어떻게 변하는지 관찰했습니다.

- 비교군: 동일한 비율(1%)의 뉴런을 랜덤하게 선택하여 제거했습니다.

- 핵심 질문: "가치 뉴런이 단지 점수를 매길 뿐인가, 아니면 추론 과정 그 자체에 개입하는가?"

예시

- Qwen-2.5-7B-SimpleRL-Zoo + MATH500

- 원래 정확도: 75.2%

- 랜덤 1% 제거 시: 74.6% (오차 범위 내 유지)

- 가치 뉴런 상위 1% 제거 시: 20.3% (약 55%p 폭락)

- 특히 특정 레이어(예: Layer 5)에서는 정확도가 1.2% (-74.0%p)까지 떨어지는 시스템 붕괴 수준의 결과가 나타났습니다.

정리

모델 종류, 크기, 데이터 도메인과 상관없이 모두 일정한 양상을 보이는 이 결과는 매우 충격적입니다. 1%라는 아주 적은 차원이 전체 추론 성능의 70% 이상을 지탱하고 있다는 뜻이니까요. 하지만 이를 "이 뉴런들이 지능의 전부다"라고 해석하기엔 무리가 있습니다. 오히려 이 뉴런들이 추론의 흐름을 제어하는 핵심 스위치나 게이트웨이 역할을 하고 있다고 보는 것이 타당해 보입니다.

특정 레이어(Layer 5)에서 유독 민감하게 반응하는 점은, LLM의 연산 과정 중 초기 단계에서 이미 성공 가능성에 따른 계산 경로 최적화가 일어났을 것이라고 볼 수도 있습니다.

4. 1%를 범용 지능이라 부를 수 있을까?

배경

- 논문이 직접 보여준 것은 범용 지능이라기보다,

- (a) 정답/오답(보상) 기대값(value) 을 담는 희소 신호가 있고

- (b) 그 신호가 추론 성능에 원인적으로 중요하며

- (c) 위치가 태스크/모델 변형에도 꽤 안정적(transferable) 이라는 점입니다.

특히 이를 정량화하기 위해 IoU(intersection-over-union)를 쓰는데,

- 동일 모델에서 태스크만 바꿔도 IoU가 랜덤 베이스라인보다 높고, pruning ratio가 99%에 가까울수록(= 핵심 차원만 남길수록) IoU가 오히려 올라갑니다.

- 예로 GSM8K vs ARC에서 99% pruning에서도 IoU > 0.6을 언급합니다.

- 또 같은 베이스(Qwen-2.5-7B)에서 RLVR로 파인튜닝한 두 모델(Qwen-2.5-7B-SimpleRL-Zoo vs RLHFlow/Qwen2.5-7B-PPO-Zero) 간에도 IoU가 랜덤보다 높다고 보고합니다.

논문이 보여주는 데이터에 따르면, 희소성을 높일수록(즉, 더 핵심적인 뉴런만 남길수록) 태스크 간의 뉴런 겹침 현상이 더 뚜렷해집니다. 이는 모델이 문제를 풀 때 사용하는 구체적인 지식은 흩어져 있을지 몰라도, 그 문제가 잘 풀리고 있는지 판단하는 내적 크리틱(Internal Critic) 체계는 매우 공통적인 병목 구조를 공유함을 의미합니다.

5. 활용을 위한 아이디어

모델이 정답을 내놓기 전, 이미 속으로 알고 있는 성공 확률을 어떻게 서비스에 녹여낼 것인가? 에 대한 아이디어를 정리해보겠습니다.

작동 원리/배경

논문이 제시한 대표 응용은 두 가지입니다.

- 신뢰도 높은 자신감(Confidence) 추출

- Verbalized Confidence (0.08): 모델에게 "너의 확신도를 0~1 사이로 말해봐"라고 했을 때의 결과입니다. 모델은 훈련된 대로 그럴듯한 숫자를 뱉을 뿐, 실제 정답 여부와 상관관계가 매우 낮습니다.

- Next-token Probability (0.09): 다음 토큰의 확률값 역시 국소적인 예측일 뿐 전체 문제의 성공 가능성을 대변하지 못합니다.

- Value Neurons (0.47): 모델 내부의 히든 스테이트에서 직접 추출한 가치 신호는 정답 여부와 가장 높은 Spearman 상관관계를 보입니다. 즉, 모델은 말로는 거짓말(할루시네이션)을 해도 머릿속(히든)에는 이미 정답 가능성을 꽤 정확히 알고 있다는 뜻입니다.

- 도파민 뉴런(Dopamine Neurons)을 통한 학습 신호 감지

- 논문은 보상 예측 오차(RPE) 신호를 담고 있는 차원을 '도파민 뉴런'이라 명명했습니다.

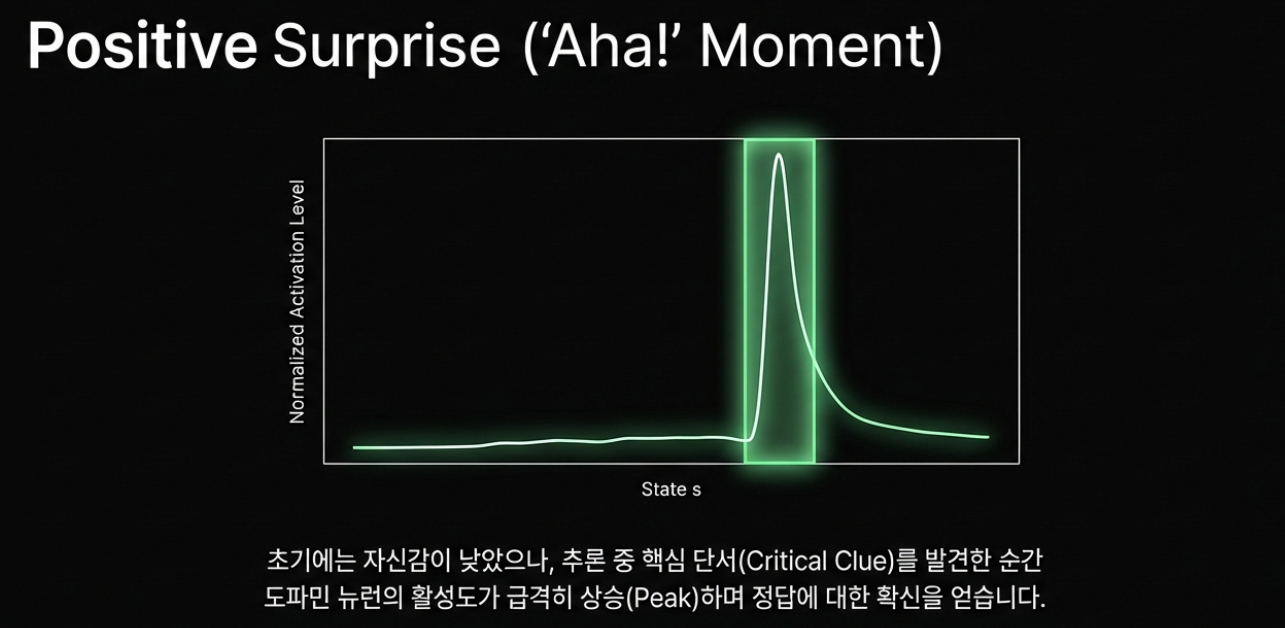

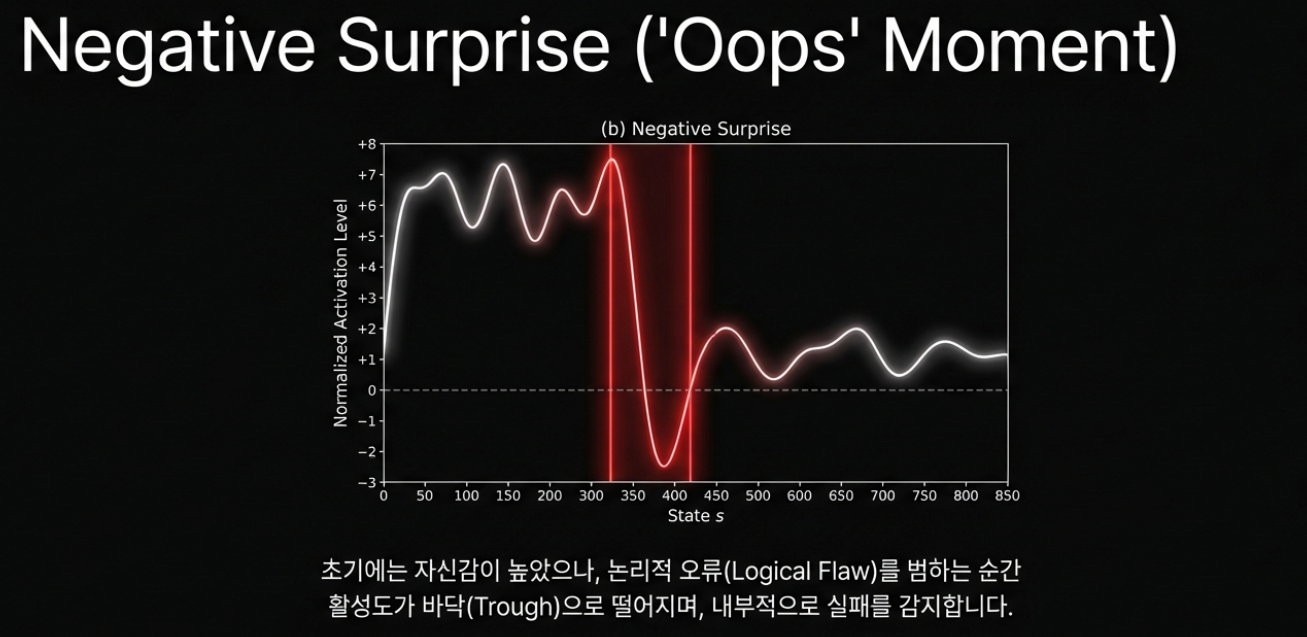

- Positive Surprise: 기대하지 않았는데 정답을 맞혔을 때 활성화되는 뉴런 (학습의 기회).

- Negative Surprise: 확신했는데 틀렸을 때 급격히 침묵(dip)하는 뉴런 (오류의 신호).

- 이러한 신호를 추적하면 모델이 생성하는 매 순간의 논리적 확신 변화를 실시간으로 모니터링할 수 있습니다.

확장 아이디어

- 라우팅(routing) / 에스컬레이션(escalation)

- value(또는 confidence)가 낮으면: 더 강한 모델로 라우팅, 사람 검토로 에스컬레이션, 혹은 도구 호출(검색/계산)로 전환

- value가 높으면 바로 응답(비용 절감)

- 적응형 추론 예산(compute budgeting)

- value 낮음 → CoT 길게, best-of-N 늘림, 검증 단계 추가

- value 높음 → 짧게, 1-shot로 끝내기

(핵심은 자기보고 confidence가 아니라 히든 기반 신호로 정책을 만든다는 점입니다.)

한계/트레이드오프

- 접근성: 이 접근은 히든 스테이트/활성값에 접근해야 하므로, API 기반 상용 모델에서는 구현 난이도가 높습니다.

- 도메인 시프트(domain shift): 수학 벤치마크에서 잘 되던 value 신호가, 고객지원/법률/의료 같은 환경에서도 동일하게 정답 가능성을 의미할지는 별도 검증이 필요합니다.

- 안전 리스크: 내부 보상을 목표로 최적화하면, 모델이 겉보기 점수 올리기로 흐를 수 있습니다(보상 해킹). 따라서 외부 검증기와 같이 써야 합니다.

논문 밖 새 아이디어 5가지

논문의 발견을 바탕으로 실제 서비스 설계에 적용할 수 있는 5가지 아이디어를 탐색해보았습니다.

- 온라인 오류 감지 및 백트래킹(Backtracking)

- CoT 생성 중 특정 단계에서 도파민 뉴런의 급격한 'Negative Surprise(활성 급감)'가 감지되면, 출력을 즉시 중단합니다. 이후 해당 시점의 가치가 높았던 이전 분기로 돌아가 다른 논리 경로를 탐색하게 함으로써 추론 성공률을 극대화합니다.

- 적응형 추론 예산 및 다단계 라우팅

- High Confidence: 내부 가치 신호가 높으면 추가 검증 없이 즉시 응답 (Latent 및 비용 절감).

- Low Confidence: 신호가 낮으면 자동으로

Self-Correction루프를 돌리거나,Majority Voting횟수를 늘리고, 필요시 더 무거운 모델(예: o1-pro)로 태스크를 이관합니다.

- 내적 캘리브레이션 기반 데이터 큐레이션

- "모델이 자신만만하게 틀린(High Value, Low Reward)" 데이터셋을 자동으로 필터링하여 미세 조정(Fine-tuning) 데이터로 우선 활용합니다. 이는 모델의 '근거 없는 자신감'을 교정하는 데 가장 효율적인 커리큘럼이 됩니다.

- 다목표 내적 크리틱(Multi-objective Internal Critic) 분해

- 정답성(Accuracy) 외에 '무해성(Harmlessness)', '도움말성(Helpfulness)'에 특화된 프로브를 각각 심어둡니다. 모델이 답변을 생성하기 전, 내부 가치 신호들이 서로 충돌하는지 감지하여 안전 가드레일로 활용합니다.

- 모델 모니터링 및 회귀 테스트 가속화

- 모델 업데이트 후 벤치마크 점수가 같더라도, 가치 뉴런의 IoU나 활성 패턴이 변했다면 모델의 내부 판단 논리가 바뀐 것입니다. 이를 통해 정량적 점수 뒤에 숨겨진 품질 저하나 동작 변화를 조기에 감지할 수 있습니다.

결론

Sparse Reward Subsystem in Large Language Models는 “LLM 내부에 내적 가치 추정(value estimation) 신호가 희소하게 존재하며, 그 일부는 추론 성능에 인과적으로 중요할 수 있다”는 점을 꽤 설득력 있게 보여준 연구입니다. 특히 MATH500에서 상위 1% value neurons 제거로 성능이 급락하고, 랜덤 제거는 거의 영향이 없었다는 결과는 이 논문을 뒷받침하는 가장 좋은 증거로 보입니다.

다만 이걸 “1%가 범용 지능의 코어다”라고 해석하기엔 섣부를 수 있습니다. 이 논문이 직접 다루는 보상은 주로 정답/오답이고, ‘뉴런’도 생물학적 실체가 아니라 히든 벡터 차원입니다. 그러므로 더 안전한 결론은, 이것이 내적 평가/비판 회로의 단서에 가깝다는 것입니다.

또 도파민 뉴런 파트는 아이디어가 매력적이지만, 현재는 케이스 기반 설득 비중이 커서, 앞으로 더 정량적인 재현, 검증이 쌓여야 할 것 같습니다.

참고 링크

- Sparse Reward Subsystem in Large Language Models (arXiv:2602.00986) (arXiv)

- SimpleRL-Zoo: Investigating and Taming Zero Reinforcement Learning… (arXiv:2503.18892) (arXiv)

- Training Verifiers to Solve Math Word Problems (GSM8K) (arXiv:2110.14168) (arXiv)

- Let’s Verify Step by Step (process supervision / MATH500 맥락) (arXiv:2305.20050) (arXiv)